SIGCOMM ’25: ACM SIGCOMM 2025 Conference September 8 – 11, 2025

Coimbra, Portugal Conference Sponsors: SIGCOMM

1. 研究背景与动机

1.1 大规模数据中心网络迁移的复杂性

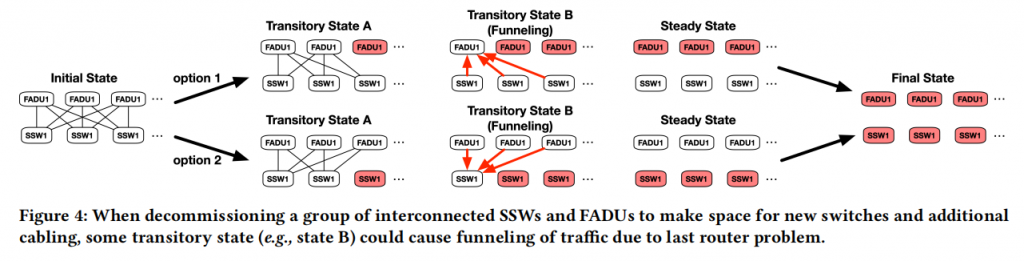

随着 AI 训练和云服务需求的激增,数据中心(DC)网络需要频繁进行架构升级(如从四级 Clos 拓扑迁移到更复杂的架构)。在这种超大规模环境下,迁移不是简单的“开关”操作,而是一个跨越数周、涉及成千上万台设备的渐进过程。在迁移期间,网络处于一种“中间状态”,新旧协议(如 BGP 与 Open/R)必须并存,这导致了路由状态的爆炸式增长。传统的硬编码脚本或人工规划无法处理这种规模的变更,任何微小的配置错误都可能引发全网范围的流量黑洞或路由环路。

1.2 传统分布式路由与集中式控制的权衡

在 Meta 的生产环境中,分布式路由协议(如 BGP)保证了网络的弹性和局部快速收敛。然而,在迁移场景下,分布式协议缺乏全局视野,难以实现复杂的流量调度目标。传统的 SDN(软件定义网络)虽然提供了集中控制,但完全取代分布式协议会带来极高的系统复杂性和风险。如何在保留分布式协议健壮性的同时,引入集中式规划的灵活性,成为了 Meta 工程师面临的首要难题。

1.3 现有迁移工具的局限性

早期的迁移工具(如静态配置文件生成器)往往是针对特定拓扑设计的“一次性”方案。它们缺乏对网络实时状态的感知能力,且难以验证迁移中间状态的安全性。当面对 Meta 这种异构、多层级的复杂网络时,这些工具在可扩展性、通用性和容错性上表现乏力,迫切需要一个统一的、声明式的规划框架来自动化这一过程。

2. 核心挑战

2.1 路径爆炸与计算效率挑战

在拥有数万个节点的 Clos 拓扑中,节点间的潜在路径数量是天文数字。Centralium 需要在迁移的每一个微小步骤中,计算并验证所有受影响节点对之间的可达性和路径偏好。这种“路径爆炸”问题使得传统的全图遍历算法在性能上无法接受。如何在保证规划准确性的前提下,利用拓扑的对称性和抽象模型来压缩计算空间,是实现大规模实时规划的核心难点。

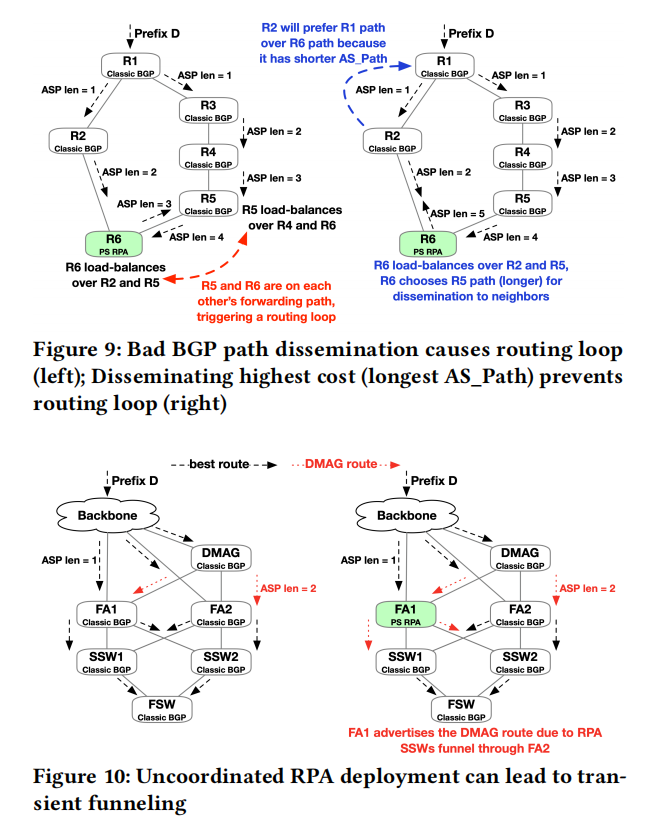

2.2 混合路由下的策略一致性

Centralium 的核心思想是“集中式规划,分布式执行”。这意味着它需要生成 BGP 策略(如 Local Preference、Community tags)来操纵分布式路由器的决策。挑战在于:如何确保集中式计算出的“预期路径”能够通过复杂的分布式协议交互精准实现?由于 BGP 的收敛过程是异步且受局部配置影响的,如何防止在策略下发过程中产生瞬时的路由震荡或策略冲突,需要极高精度的建模。

2.3 迁移过程中的“不间断服务”保障

数据中心迁移要求对业务近乎零感知。这意味着在路由协议切换、链路权重调整的过程中,不能出现流量中断。系统必须能够预测每一个操作对全网流量分布的影响,并预留足够的带宽冗余。在数万次微小的配置变更中,只要有一次规划失误导致负载不均,就可能引发拥塞甚至连锁故障。

3. 系统架构深度解析

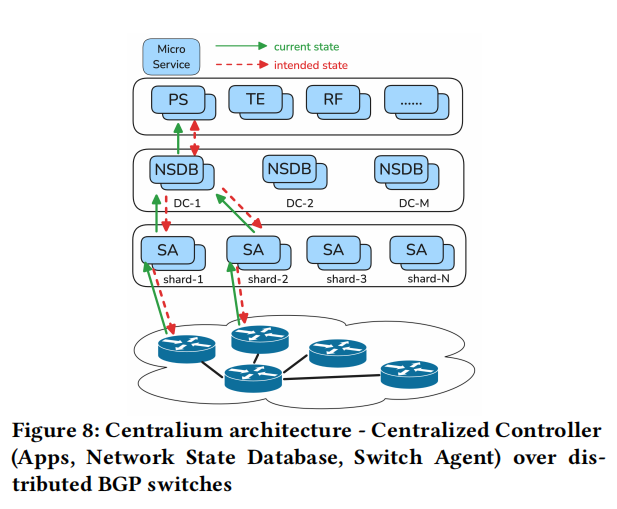

3.1 抽象数据模型:网络状态的“数字孪生”

Centralium 的底层是一个高度抽象的网络模型。它不再直接操作底层的厂商命令行,而是将设备、链路和协议策略抽象为统一的 JSON/Thrift 格式。

通过这种抽象,Centralium 构建了网络的“数字孪生”。它能实时摄取来自生产环境的实际状态(Actual State),并将其与迁移目标对应的意图状态(Intended State)进行比对。这种模型屏蔽了不同硬件和协议版本的差异,使得规划引擎可以专注于高层逻辑。

3.2 声明式规划引擎:从“如何做”到“想要什么”

与传统的命令式脚本不同,Centralium 采用声明式编程。工程师只需定义最终的路由目标(例如:将流量从旧 Fabric 转移到新 Fabric),规划引擎会自动分解为成千上万个原子的 BGP 配置变更步骤。

引擎内部集成了复杂的约束求解器,能够自动检测潜在的逻辑环路。它通过一种“增量更新”机制,仅计算受影响的路由子集,极大地提升了在大规模拓扑下的运行效率,将原本需要数小时的人工规划缩短至秒级。

3.3 验证与执行链路:闭环安全控制

Centralium 不仅仅生成计划,它还包含一个严格的验证反馈环。在配置下发前,计划会通过静态分析引擎验证是否满足连通性要求;下发过程中,系统会实时监控路由收敛情况。如果实际观察到的路由指纹(Route Fingerprint)与规划的不符,系统会自动触发回滚。这种“规划-执行-监控-校准”的闭环设计,是其能够支持 Meta 全球数据中心大规模迁移的信心来源。

4. 实验与评估详细解析

4.1 实验规模与真实环境部署

Centralium 并非实验室原型,而是已在 Meta 生产环境运行多年的成熟系统。实验数据涵盖了对数个超大规模 AI 训练集群和标准计算集群的迁移记录。实验中对比了人工脚本、传统的集中式规划器与 Centralium 在处理相同规模迁移任务时的表现。

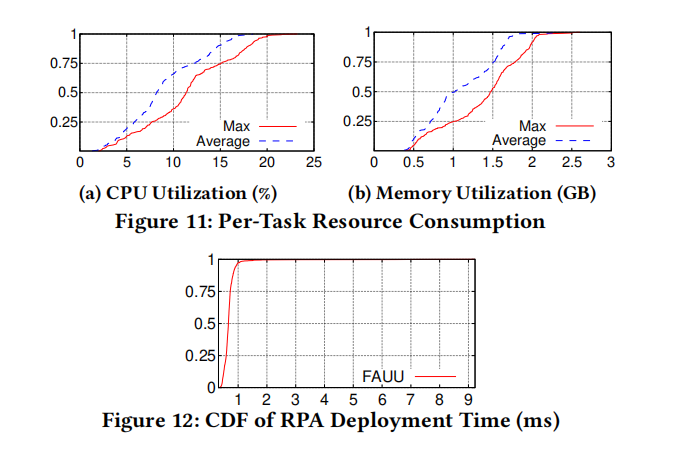

4.2 性能表现:计算开销的指数级下降

在包含 40,000+ 个节点 的模拟拓扑中:

- 规划速度:Centralium 生成一个完整的、涉及数千条链路变更的迁移序列仅需不到 2 分钟,而传统方法由于路径搜索算法的限制,往往需要数小时甚至直接内存溢出。

- 增量验证:得益于其独特的拓扑抽象,验证一个变更步骤的正确性只需 150ms,这使得实时在线验证成为可能。

4.3 安全性与可靠性量化

在过去两年 Meta 的实际迁移案例中:

- 零重大故障:Centralium 成功支撑了数百次拓扑变更,期间未发生一起由于规划逻辑错误引起的生产事故。

- 自动纠错:实验记录显示,在约 3% 的迁移步骤中,Centralium 成功检测到了由于底层硬件异常导致的状态不一致,并自动中断了迁移序列,防止了故障扩散。

4.4 灵活性:支持异构迁移

实验还展示了 Centralium 在多种复杂场景下的通用性:

- 协议切换:成功执行了从 BGP 到 Open/R 的混合路由无损迁移。

- 拓扑升级:支持了从 H-Clos 拓扑向 Meta 下一代 AI 网络架构的平滑过渡。 实验证明,该框架不仅提升了效率,更重要的是通过“混合路由规划”这一理念,完美兼顾了集中管理的便利性与分布式系统的健壮性。

5. 总结与展望

5.1 核心价值总结:从“手动管理”到“意图驱动”的跨越

Centralium 的成功不仅在于它解决了一个具体的工程难题,更在于它确立了超大规模网络治理的新范式。

- 范式转型:它将网络迁移从“关注配置细节(BGP 属性、命令行)”转变为“关注宏观意图(流量目标、可达性约束)”。通过混合路由架构,它在分布式协议的“高可用性”和集中控制的“全局最优性”之间找到了黄金平衡点。

- 可靠性基石:在 Meta 这种级别的生产环境中,能够实现 100% 的迁移逻辑正确率,证明了其“声明式规划+闭环验证”机制的强大生命力。它不仅是迁移工具,更是网络韧性(Network Resilience)的重要支撑系统。

5.2 局限性思考:当前的边界

尽管 Centralium 表现卓越,但论文中也隐含了其适用范围的局限性:

- 协议依赖性:目前的优化高度针对 BGP 和 Open/R 协议。如果数据中心引入了全新的非最短路径优先(Non-SPF)或自定义的专有路由协议,其抽象模型可能需要大规模重构。

- 计算复杂度的极端情况:虽然通过对称性压缩了搜索空间,但在面对极度非对称(如大规模设备老化丢包或多点并发故障)的拓扑时,规划引擎的收敛速度仍有提升空间。

5.3 未来展望:AI 驱动与全自动自愈

基于 Centralium 的架构,未来的研究方向呈现出以下趋势:

- 引入生成式 AI 进行规划决策:目前的规划引擎基于硬编码的约束逻辑。未来,利用 LLM(大语言模型)理解复杂的自然语言策略,并自动将其转化为 Centralium 的声明式模型,将进一步降低运维门槛。

- 全自动异常自愈(Self-healing):目前 Centralium 主要用于主动迁移。未来,该框架可以扩展为“常驻监控者”。当网络发生非预期的物理故障时,Centralium 可以像计算迁移计划一样,自动计算并下发“抢修路由计划”,实现秒级的故障自愈。

- 跨云与边缘扩展:随着边缘计算的发展,如何将这种混合路由规划框架从单一数据中心扩展到跨地域、跨云的异构链路,将是网络测量与控制领域的下一个前沿课题。