作者:Akash Karthikeyan, Yash Vardhan Pant

问题背景与动机

自我对弈(self-play)强化学习在博弈性和多智能体任务中已被证明能够学习复杂策略,但在连续动作空间、对手多样性 以及 泛化性 方面仍存在显著挑战,包括:

- 传统 RL 方法对连续、复杂策略空间的收敛速度慢甚至不收敛;

- 所学策略容易被未见对手策略利用,缺乏鲁棒性;

- 与 Nash 均衡的收敛性理论保证弱。

这些问题在零和多智能体环境(如赛车、物理粒子竞赛、连续策略博弈)中尤为明显:策略空间大、状态/动作连续、对手行为多变。DiffFP 提出了一种结合虚构博弈(Fictitious Play) 与扩散策略生成模型(diffusion policy) 的框架,以此提升适应性、鲁棒性与多样性。

核心方法:DiffFP 框架

DiffFP 是一个 迭代的自博弈框架,其目标是在连续空间的零和博弈中逼近 ε-Nash 均衡,主要由两个核心组成部分构成:

- Fictitious Play:用于估计对手策略分布

- Diffusion Policy:用于学习对当前 opponent 分布的 best response(最佳应对)

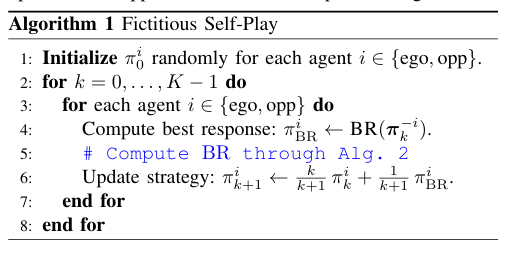

1. Fictitious Play 机制

在每一轮训练中:

- 记对手策略分布为 π⁻ (opponent policy distribution),这是根据以往自我对战经验(历史策略)累积得到的经验策略混合;

- 智能体则针对 π⁻ 学习其 最佳响应策略 π*;

- 每轮迭代结束后,将新策略加入历史对手集合,更新 π⁻。

传统 Fictitious Play 使用逐步 best response / empirical distribution 机制更新策略集,而 DiffFP 用扩散策略代替传统策略网络,以便捕获多峰行为及适应性强的策略分布。

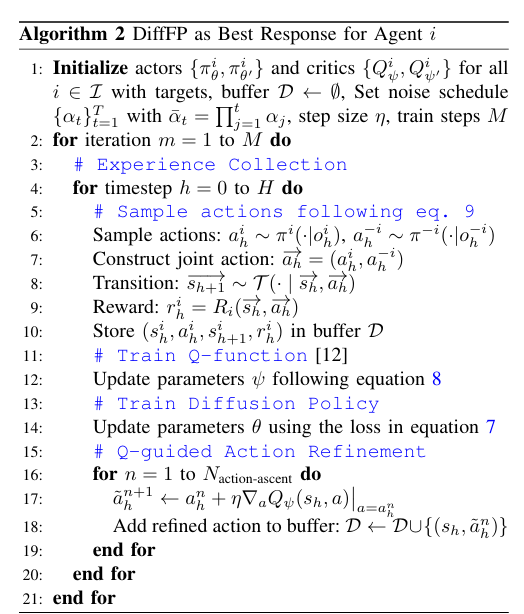

2. Diffusion Policy 作为 Best Response Learne

Diffusion 模型在生成模型中是一类通过从噪声开始逐渐去噪得到目标分布的模型(如 Gaussian diffusion)。DiffFP 利用这种机制来生成策略(action 或 action sequence):

- score network 学习目标动作序列生成分布;

- 智能体执行从噪声中反向去噪得到的策略序列;

- 这种生成方式可以实现策略的多样性与覆盖性,克服 RL 中策略过早收敛到局部最优、策略单一等问题。

Folded into Fictitious Play 中的 best response 训练流程,DiffFP 每一轮进行:

- 采样对手策略 π⁻;

- 使用 diffusion policy 来生成 candidate 动作策略;

- 评估这些策略在当前对手分布下的累计 payoff;

- 更新 diffusion score network 以使生成的策略逼近 best response;

- 将 learned policy 加入历史集合。

这种设计的优点包括:

- 生成策略具有多模态能力(比传统单一参数化策略更具适应性);

- diffusion 模型天然实现从 exploration(多样动作) 到 exploitation(强动作)的连续平衡;

- 适合连续动作空间与连续时域的博弈。

算法结构与训练流程

整个 DiffFP 框架大致如下:

1. 初始化

- 初始化策略生成模型(扩散 policy)与空白历史策略集合 H;

- 初始化对手策略分布 π⁻ as uniform / random。

2. 迭代循环

对于第 轮迭代:

Step 1 — 更新对手分布 π⁻

对手分布是基于历史联盟 H 的经验频率,这里每个历史策略有相应权重:

这里的策略集合 H 随着迭代增长。

Step 2 — 基于 π⁻ 生成策略候选

使用 diffusion policy 的 score network,从 Gaussian 噪声生成 candidate strategies:

这里状态 st 是当前博弈状态。

Step 3 — 评估与 Dyson 学习

对于生成的候选策略:

- 估计期望 payoff;

- 使用 RL/优化方法调整 score network 使其生成更高表现策略。

目标是最小化对自己策略与 best response 之间的 KL divergence 或提升 expected payoff:

这一步通过标准 gradient descent 更新 score network 参数 θ。

Step 4 — 更新历史集合

将新策略加到历史 H 中:

然后进入下一轮迭代。

3. 收敛判据

DiffFP 证明在连续空间零和博弈中其迭代过程在理论上可逼近 ε-Nash 均衡(strategy profile 使任一玩家偏离收益提升 ≤ ε 的情况),使得所得策略集比传统 RL 更具理论保证(尽管具体收敛速度与环境有关)。

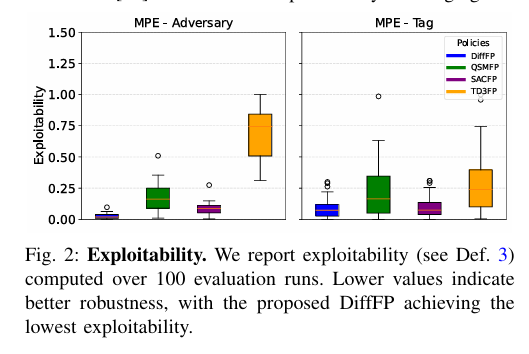

实验设置与主要结果

DiffFP 在多个复杂连续空间任务中进行了测试,包括:

- 连续动作零和赛车(racing)环境;

- 多粒子零和游戏(multi-particle zero-sum games)。

主要实验指标包括:

- 收敛速度:达到某一胜率 / payoff threshold 所需的迭代次数;

- 成功率:对抗 diverse opponents(多种对手策略)时的胜率;

- 鲁棒性:在训练过程中不同迭代间性能稳定性。

结果摘要:

- DiffFP 比常规模仿 self-play RL 方法收敛速度快 最多 3×;

- 在对抗 diverse opponents 时成功率平均提高 30×;

- learned policies 在训练迭代间表现更加稳定且不易被 exploit。

这些结果表明 diffusion policy 在生成对抗策略方面比普通参数化策略表现更鲁棒且具有更好的 generalization ability。

技术挑战与机制分析

1. 为什么 diffusion policy 有优势?

- 多模态策略生成:普通强化学习策略往往被限制在单一峰值或局部最优。扩散模型学习的是整个策略分布,通过 denoising 过程天然实现从 exploration 到 exploitation。

- 连续空间适应性强:在连续动作 /连续状态博弈中,diffusion 模型不依赖 discretization,可以直接在高维空间生成 diverse 动作序列。

2. Fictitious Play 的强化

传统 FP 在多智能体环境中容易陷入循环或收敛慢。DiffFP 通过:

- 用生成模型 Approximate best response;

- 对手分布并不假设对手固定,而是根据历史经验频率动态更新;

强化了 FP 的泛化性与对抗稳定性。

限制与未来方向

论文也指出若干常见限制与未来改进方向:

- 计算资源消耗:扩散模型训练本身较重,对比传统策略网络需要更多计算;

- 对手模型假设:fictitious play 假设 opponent behavior 准确反映历史分布,而在对手主动 adaptive 的场景可能存在偏差;

- 泛化到更多任务:虽已验证在连续零和环境,是否能无调参泛化到更多复杂博弈结构还需进一步实验。

结论

DiffFP 提出了一种创新性框架,将生成式扩散模型与博弈论中的虚构博弈相结合,使得自我对弈策略学得更具多样性、鲁棒性与泛化能力。实验结果显示在连续空间博弈中比基础 RL baselines 具有显著的性能优势。