1. 研究动机与背景

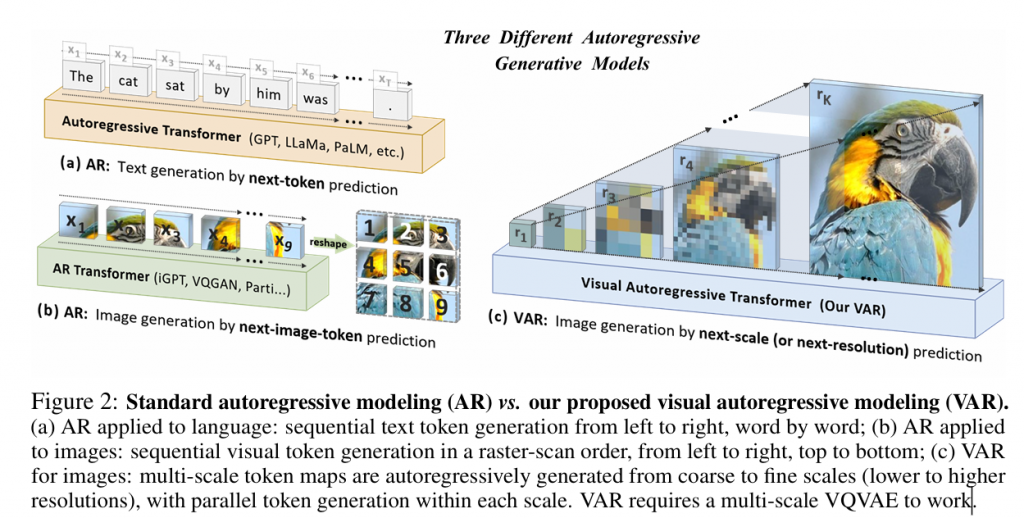

传统的视觉 自回归(Autoregressive,AR)生成方法通常按光栅扫描(raster-scan)的顺序逐像素或逐 patch 预测下一个 token,而这种策略:

- 忽略图像的二维结构;

- 难以并行计算;

- 在生成质量和生成速度上落后于扩散模型(如 Stable Diffusion / DiT)。

与此同时,自回归模型在自然语言处理中(例如 GPT 系列)展现出可扩展性(scaling laws)和零样本泛化能力等优势,但这些特性尚未在视觉生成领域得到充分利用。

本论文提出了一种全新视觉生成范式 Visual AutoRegressive Modeling(VAR),通过从粗到细的**尺度预测(next-scale prediction)**替代传统光栅预测,使自回归模型能在图像生成中同时兼顾质量和高效性。

2. 核心方法:VAR(Visual AutoRegressive Modeling)

VAR 的核心思想是:

将图像生成任务看成一系列“从低分辨率向高分辨率的预测”,而不是一个长序列 token 的逐点生成功能。

2.1 从粗到细的 Next-Scale 预测

VAR 将图像划分成多个尺度(scale)表示:

- 每个尺度对应图像的不同分辨率 token map;

- 模型按照尺度顺序(例如 1×1 → 4×4 → 16×16 → 64×64)自回归地预测下一级更高分辨率的 token map;

- 模型不再按像素顺序预测单个 token,而是按整个尺度 token map作为一个自回归单元。

如数学表达:p(r1,r2,…,rK)=k=1∏Kp(rk∣r1,r2,…,rk−1),

其中 rk 是第 k 个尺度的 token map。

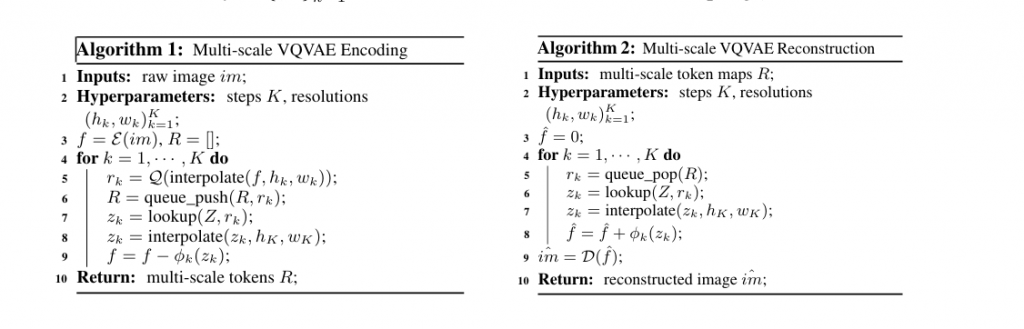

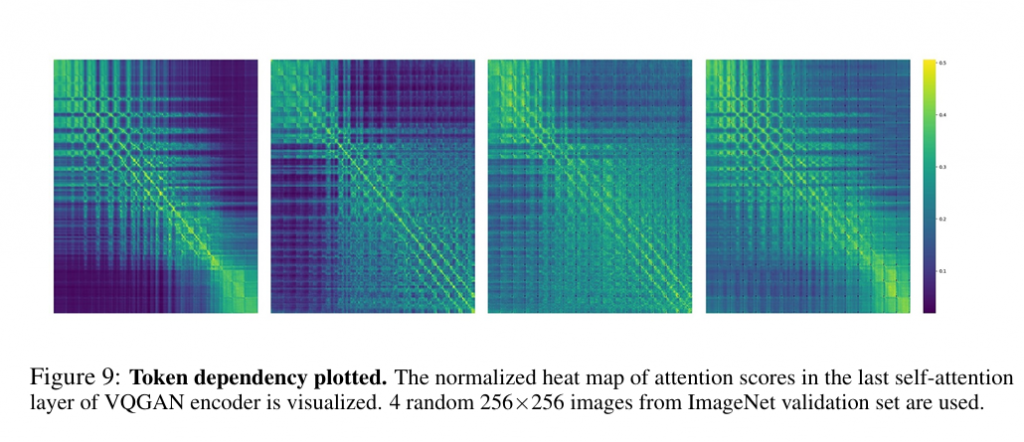

2.2 多尺度编码(Multi-Scale Quantization)

为了支持上述机制,VAR 引入了一个多尺度量化编码模块:

- 使用类似于 VQ-VAE 的机制,将原图编码成分层 token maps;

- 不同尺度的 token maps 共享一个 codebook,使得跨尺度保持一致的 token vocabulary;

- 编码器负责将图像映射为一系列尺度的 token map,而解码器负责将最后预测的 token maps 复原为图像。

这种分层表示方式有利于捕捉全局结构(在低尺度)和细节信息(在高尺度)之间的依赖关系,有效模拟自然图像的生成过程。

2.3 VAR Transformer 架构

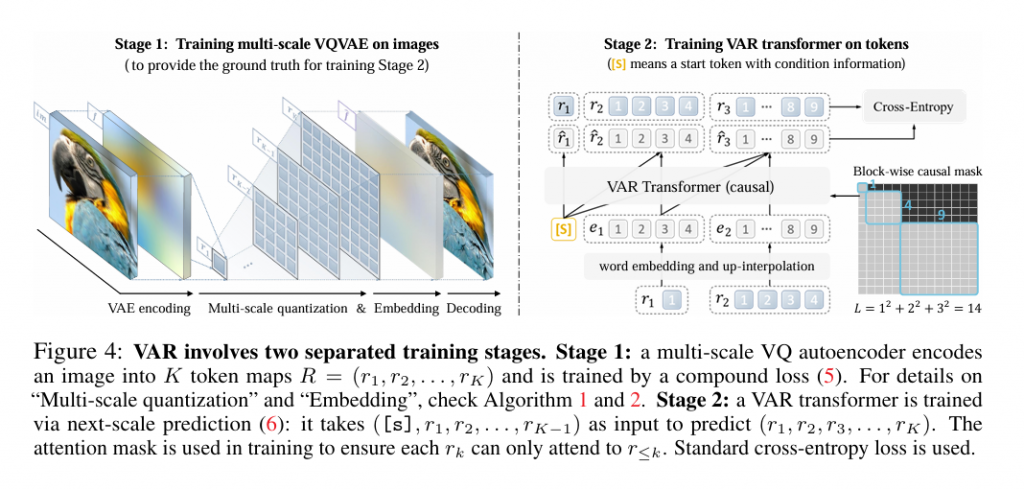

在编码完成后,用一个自回归 Transformer 模型预测下一个尺度:

- 输入:当前已有的低尺度 token maps;

- 输出:下一级尺度所有 token;

- 注意力机制设计保留尺度之间的自回归关系,同时允许同尺度内的并行预测;

- 训练损失采用标准的交叉熵(cross-entropy)损失来最大化条件概率 p(rk∣r<k)。

这种结构区别于传统 AR 模型逐 token 顺序预测的粒度,使预测过程更高效、层次更清晰。

3. 与现有方法的比较

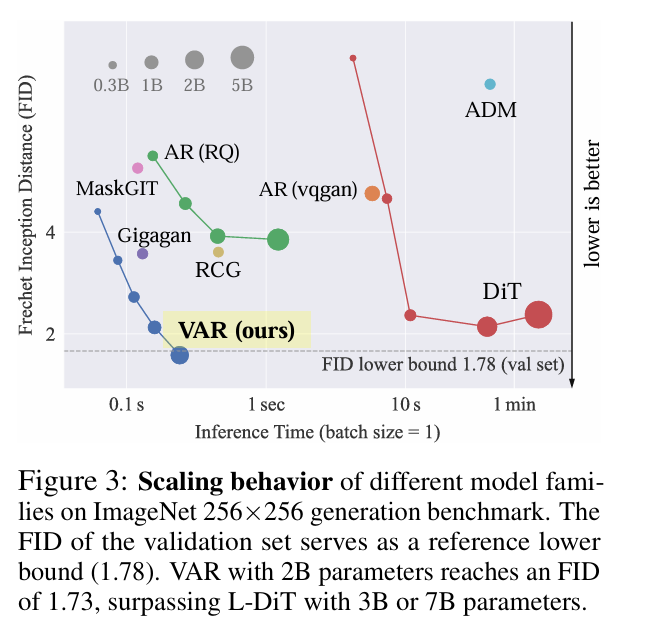

本论文从多个维度对 VAR 与其它生成模型进行了评估:

3.1 与传统 AR 模型对比

- VAR 相比传统 AR baseline 在 ImageNet 256×256 数据集上有显著提升:

- Fréchet Inception Distance (FID) 从 18.65 提升到 1.73;

- Inception Score (IS) 从 80.4 提升到 350.2;

- 推理速度提升约 20×。

这种提升表明采用尺度预测不仅保证了生成质量,还极大提高了效率。

3.2 与扩散 Transformer(如 DiT)对比

- 在图像质量、推理速度、数据效率和可扩展性等多个指标上,VAR 都优于扩散式模型;

- 扩散模型虽然生成质量高,但推理速度慢、需较多采样步骤,VAR 在这些方面展现更优平衡。

4. Scaling Laws 与泛化能力

4.1 Scaling Laws(扩展定律)

论文实验证明 VAR 在模型规模与 compute 资源变化时遵循幂律扩展定律(power-law scaling laws):

- 随着模型参数量和训练数据规模的扩大,生成质量(如 FID/IS)呈现有规律的线性提升;

- Pearson 相关系数近 −0.998,说明这种定律非常稳定。

这一点与大语言模型(LLMs)在 natural language 任务上的 scaling laws 极为相似,表明视觉自回归模型具有类似通用性和可扩展性。

4.2 零样本泛化能力(Zero-Shot Generalization)

VAR 在下列下游任务上均展示了无需额外训练的泛化能力:

- 图像 in-painting(局部修复);

- out-painting(边界扩展生成);

- 图像 editing(编辑语义改变)等。

这说明 VAR 不仅适合纯图像生成,还可作为通用视觉生成模型的一部分,类似 LLM 在语言任务的通用性。

5. 数学与训练细节

- 训练过程分为两个阶段:

- 多尺度编码器训练:学习从图像到尺度 token maps 的编码;

- VAR transformer 训练:基于 cross-entropy 最大化目标训练尺度预测变压器。

- 注意力掩码被设计为确保尺度间自回归关系正确,即预测一个尺度时仅能看到更粗尺度及自身已生成的上下文。

- 模型可用标准 GPU/分布式架构训练;论文也开源了代码与预训练模型。

6. 核心贡献与意义

该论文的主要贡献包括:

- 提出视觉自回归生成范式 VAR:通过“下一尺度预测”替代传统光栅扫描,提高了 AR 图像生成的效率与质量。

- 首次使 AR 模型在生成质量和效率上超越扩散 Transformer:在标准 benchmark 上表现优异。

- 验证视觉 AR 也具有 LLM 样的 scaling laws:为统一视觉与语言生成模型架构提供重要理论依据。

- 展示零样本泛化能力:增强了视觉生成模型的适用性。

7. 局限性与未来方向

虽然 VAR 在多个指标中表现优越,但仍有一些需要进一步研究的问题:

- 更高分辨率生成的计算开销:随着尺度层数增加,模型仍需要高效的并行机制和缓存策略(如后续研究提出的 AMS-KV / FastVAR)。

- 与文本/语言联合生成的融合:目前主要用于图像生成,未来可与多模态模型融合。

- 在极高分辨率与复杂结构图像上的扩展能力。

总结:这篇论文通过一个全新且简单有效的“从粗到细尺度预测”架构,让视觉自回归模型首次在生成质量、速度和扩展性上超越扩散模型,展示出类似 LLM 的 scaling laws 和零样本泛化能力,具有重要的理论与实践意义