论文目的

系统回顾 “多模态大语言模型 (Multimodal Large Language Models, MLLMs)” 的研究进展 — 即那些不仅处理文本 (text),还能处理 / 生成图像 (image)、音乐 (music)、视频 (video)、人体动作 (human motion)、3D 对象 (3D) 等多种模态 (modalities) 的模型。

论文通过分类模态 (modalities)、总结基础技术 (foundation techniques)、分析典型模型 / 架构 /训练 /融合方式,以及讨论挑战与发展趋势,为研究者提供“从文本 LLM → 通用多模态模型”的总体路线图 (map) 。

为什么关注 MLLM / 跨模态推理

传统的“大语言模型 (LLM)”只处理文本,缺乏对图像、视频、语音、3D 等其他模态的感知和推理能力。

这六类(见图 1)代表了当前生成模型操作的主要模式,每一类都涵盖了不同形式的数据输出和独特的应用场景。

多模态生成模型的六大类别

多模态大模型(MLLMs)的生成能力已扩展到文本、图像、音频、视频等多种模态。根据输入和输出模态的不同,可以将其主要生成类别归纳为以下六种:

MLLM的核心组成与技术机制

MLLM 通过把语言模型与视觉 / 其他模态输入结合起来,能够执行诸如 “根据图片写故事”、 “从图像直接算数 (OCR free math reasoning)”、 “视觉问答 (VQA)”、 “多模态指令执行 (vision + text → action)” 等任务,这些能力是传统 unimodal 模型难以实现的。

因为继承了 LLM 的推理和生成能力 + 新增的跨模态理解能力,MLLM 被视为通向更通用、更灵活 AI 系统的重要路径之一。

架构组成

根据 survey,总体来说,一个典型的 MLLM 包含以下主要组成部分 (组件) :

大型语言模型 (LLM) backbone — 用作“脑 (brain)”或“通用理解 /生成 /推理模块 (core)”

模态编码器 (Modality encoder) — 将非语言模态 (如图像、音频、视频、3D、动作等) 转换为 feature embeddings,使其能够被 LLM “理解 /处理 /融合”。

连接 / 适配模块 (connector / adapter / vision-to-language adapter / modality adapter) — 用于将 Encoder 输出 (非语言特征) 转换 /对齐 (alignment) 到 LLM 的 embedding / token 空间,使 LLM 能够跨模态推理 /生成 /融合。通常有投影 (projection-based)、查询 (query-based)、融合 (fusion-based) 等不同连接方式。

(可选) 生成模块 / decoding module — 当需要生成非文本模态 (例如图像、视频、3D、动作等) 输出时,可能额外附带一个 generator / decoder,用于将 LLM + multimodal embedding 转换为目标模态输出。

这个架构设计使得 MLLM 在多模态任务上能够统一使用一个“核心 + 感知 + 适配 + 生成”的 pipeline。

通用技术 (Foundation Techniques)

为了实现跨模态能力与通用性,论文总结了当前 MLLM 主要依赖的几类基础方法 /技术:

自监督学习 (Self-Supervised Learning, SSL) — 用于预训练模态编码器 / 特征提取器,使其能够从大量未标注 /弱标注的数据中学习通用表示 (representation)。

专家混合 (Mixture of Experts, MoE) — 在多模态 + 多任务 + 大规模模型场景下,通过专家 (experts) 分支 /模块化设计,使模型具有良好扩展性与专门化能力 (某些专家负责某些模态 /任务),同时控制计算 /参数复杂度。

从人类反馈强化学习 (Reinforcement Learning from Human Feedback, RLHF) — 用于微调 (fine-tune) 模型,使其输出符合人类偏好 /安全 /质量 /一致性 /可控性 (尤其多模态生成 /推理输出的对齐与安全性)。

提示 + 推理链 (Prompting & Chain-of-Thought, CoT) — 扩展到多模态场景 (如视觉 + 文本 + 推理),让模型通过“多模态 CoT / multimodal CoT / M-CoT”、“多模态 in-context learning (M-ICL)”等方式,增强跨模态推理能力与通用性 (few-shot / zero-shot / instruction-following) 。

这些基础技术 /方法构成了 MLLM 从单模态 → 多模态、从识别 /分类 → 生成 /推理 /通用能力 (generalist) 的基石。

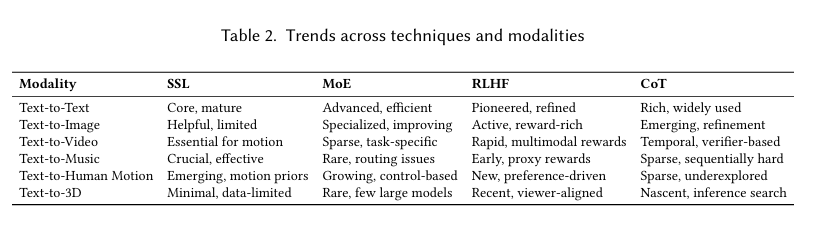

技术的协同组合:尽管每种技术各自具有独特的优势,如数据效率、模块化可扩展性、一致性或结构化推理,但它们最大的潜力在于组合使用。整合自监督学习(SSL)、专家模型(MoE)、强化学习与人类反馈(RLHF)以及链式推理(CoT)可以培养出不仅更连贯、更可控,而且在跨模态和跨任务的泛化能力上更强的模型。这种汇聚使多模态生成模型(MGM)能够进行更深入的推理、以更结构化的方式进行规划,并以更精细的粒度响应,从而为实现更可解释和自适应的多模态智能铺平道路。值得注意的是,每种技术在不同模态上的发展和采用程度差异较大,这反映了数据可用性、架构限制和任务特定挑战的不同,如表 2 所总结。

模型能力 & 应用 / Emergent 功能

得益于上述架构设计 + 技术 /训练方法,MLLM 展现出传统 “文本模型 + 单模态 (图像分类 / caption / 检索)” 无法轻易实现的功能 / emergent 能力,包括:

图片 → 故事 / 描述 /自然语言生成:例如给定图像 (或多图像),生成连贯、富语义、具上下文 /情节 /逻辑的文本 (故事、描述、解释等)。这比传统 captioning 更灵活 /丰富。

图像 + 文本 → 跨模态推理 /回答 (Visual Question Answering, VQA):结合视觉 + 语言理解 + 推理 (逻辑、常识、上下文) 来回答与图像内容相关的问题。

无需 OCR 的图像数学 /推理能力 (OCR-free math reasoning):这意味着模型可以直接“看到”图像 (比如图表 / 数学题 /手写字 /公式),理解内容并进行推理 /计算,而不必须先通过文字提取 / OCR。

多模态生成 (Cross-modal generation):不仅仅是图像 → 文本,还可能是文本 → 图像 /视频 /3D /动作 /音频等 (当模型集成 generator / decoder 时),让模型具备多样的感知 + 生成能力,实现真正的“通用多模态大模型 (generalist multimodal model)”。 这是该 survey 所强调的 MLLM 发展方向之一。

综上,MLLM 的能力已超出了传统 vision-language / multimodal classification / retrieval / captioning 的范畴,更接近于一种“通用智能 (generalist intelligence)”系统。

挑战、问题与开放方向

论文也对 MLLM 当前 /未来发展所面临的问题进行了分析与总结。主要包括:

多模态 “幻觉 (hallucination)” — 当模型在视觉 + 语言融合 /生成 /推理时,有可能 “想象 /编造 (hallucinate)” 出与输入模态 (例如图片) 不符的内容 (objects /细节 /逻辑),导致输出不可靠 /不真实。

评估 (Evaluation) 的困难 — 传统对视觉语言模型 (vision-language models) 的评估 (如 captioning、VQA) 任务 / benchmark 不足以覆盖 MLLM 的“跨模态 + 推理 + 生成 + 复杂输出 + 多任务 /多场景”能力。需要新的、更通用 / 综合 /系统化的 benchmark 和评测指标。

模态 /任务 /生成类型的扩展 & 通用性 (Modality / Task / Output Generalization) 难题 — 虽然 MLLM 支持多模态,但从“视觉 + 文本”扩展到“视频 / 动作 /3D /音频 /音乐 /复杂生成 /跨任务”等时,设计、训练、对齐 (alignment)、数据支持、生成器 / decoder 等都很复杂,目前还缺乏成熟统一框架 /系统。

效率 /资源 /部署问题 (Cost & Deployment) — 多模态 + 大模型 + 多任务 / 多输出 = 高算力、海量数据需求。训练成本高,推理 /部署 (尤其在资源受限环境 / edge / mobile) 难度大。论文认为研究 “高效 /轻量 /模块化 /可扩展 /资源友好” 的 MLLM 是一个重要方向。

可控性 /对齐 /安全 /鲁棒性 /可解释性 (Alignment, Safety, Interpretability, Robustness) — 随着模型能力越来越泛、输出越来越多样 (文本 /图像 /3D /动作等),如何保证模型输出安全 /可靠 /符合伦理 /没有偏差 /对抗 /隐私 /误用风险,是重大挑战。尤其当输出包括图像 /视频 /3D /动作 /其他模态时。 论文建议未来研究对此给予更多关注。

未来方向 & 作者建议

基于对现状与挑战的分析,论文提出了若干未来研究 /发展建议 /可能方向 (critical paths toward general-purpose multimodal systems) :

扩展新的模态 & 输出类型 — 除了图像 + 文本 + 视频 + 3D + 动作,还可能加入 音频 /音乐 /语音 /多语种 /跨文化 /跨领域 模态。构建更通用、更灵活、更强大的多模态系统。

构建更系统 /综合 /标准化的评估 benchmark — 覆盖多模态理解 (perception)、推理 (reasoning)、生成 (generation)、多任务 (多模态 +多任务)、通用性 (generalization)、安全 /健壮性 /对齐 /可控性 等维度。解决当前 benchmark /评估体系碎片化 /不全面的问题。

提升模型效率 /轻量化 /资源友好型设计 — 例如模块化、专家混合 (MoE)、知识蒸馏 (distillation)、量化 (quantization)、剪枝 (pruning)、efficient architecture / adapter / connector 设计等,以便更好地部署到边缘 /移动设备 /资源受限环境。

加强对齐 /安全 /可控 /可解释 /可信 (alignment / robustness / interpretability / trustworthiness) — 包括减少 hallucination /错误 /偏差 /不安全输出;增强输出的一致性、可控性、可解释性;设计人类反馈 /规则 /限制 /对齐机制等。

促进跨模态 /跨任务 /跨场景 /跨领域通用性 (Generalist, cross-domain / cross-modality / cross-task) — 鼓励研究不仅专注于图像+文本,还兼顾视频 / 动作 /3D /音频 /跨语种 /跨文化 /实际应用 (医学、科学、工程、社会 …) 等更多场景。

背骨 (backbone) 通常是大型语言模型 (LLM) —— 负责语言理解与生成。

增加“视觉 (或多模态) 编码器 (vision / modality encoder)” — 将图像 (或视频/音频/3D/其他模态) 转换成一组 feature embeddings,以便与语言 token 在同一空间 / 序列中交互。

接着是“跨模态融合 (cross-modal fusion / alignment)”模块 — 用于将不同模态 (视觉 + 文本 + …) 的表示整合起来,使模型能够“理解”复合输入 (例如 “图片 + 提问” -> “回答”)。

有些系统采用模块化 / 可扩展设计 (modular / mixture-of-experts 结构),以支持多种模态/多任务/多语言。