会议:ICML 2025(第42届国际机器学习大会)

Dongzhi Jiang∗ 1 , Renrui Zhang∗† 1 , Ziyu Guo2 , Yanwei Li‡3 , Yu Qi‡4 , Xinyan Chen‡1

Liuhui Wang‡5 , Jianhan Jin‡6 , Claire Guo‡7 , Shen Yan3 , Bo Zhang8

Chaoyou Fu6 , Peng Gao8 , Hongsheng Li1

arXiv:2502.09621v1 [cs.CV] 13 Feb 2025

1 CUHKMMLab 2CUHKMiuLarLab 3 ByteDance 4 NEU 5 UPenn

6 NJU 7CUHK(Shenzhen) 8 Shanghai AI Laboratory

{dzjiang,renruizhang}@link.cuhk.edu.hk

∗ Core contribution † Project lead ‡ Equal contribution

Project Page: https://mmecot.github.io/

这是目前多模态大语言模型(MLLM)领域首个系统评估**思维链(Chain-of-Thought,CoT)**在多模态推理任务上的质量与局限性的研究。该论文提出新的评测框架,并从多个维度分析最先进模型的表现,为后续跨模态推理研究提供了重要参考。

一、研究动机与背景

大型语言模型(LLMs)中**思维链提示(CoT prompting)通过逐步生成推理步骤显著增强语言推理能力。然而,在多模态大语言模型(LMMs)**中,这一机制的作用尚未被系统研究:

- 传统 CoT 在文本推理中能提高逻辑清晰度和推理能力,

- 但对图像、空间信息或视觉逻辑推理是否同样有效并不清楚。

因此,该论文提出专门用于多模态推理的基准与评估体系,以实证方式检测 CoT 在视觉-文本推理中的效力与弊端。

二、核心贡献

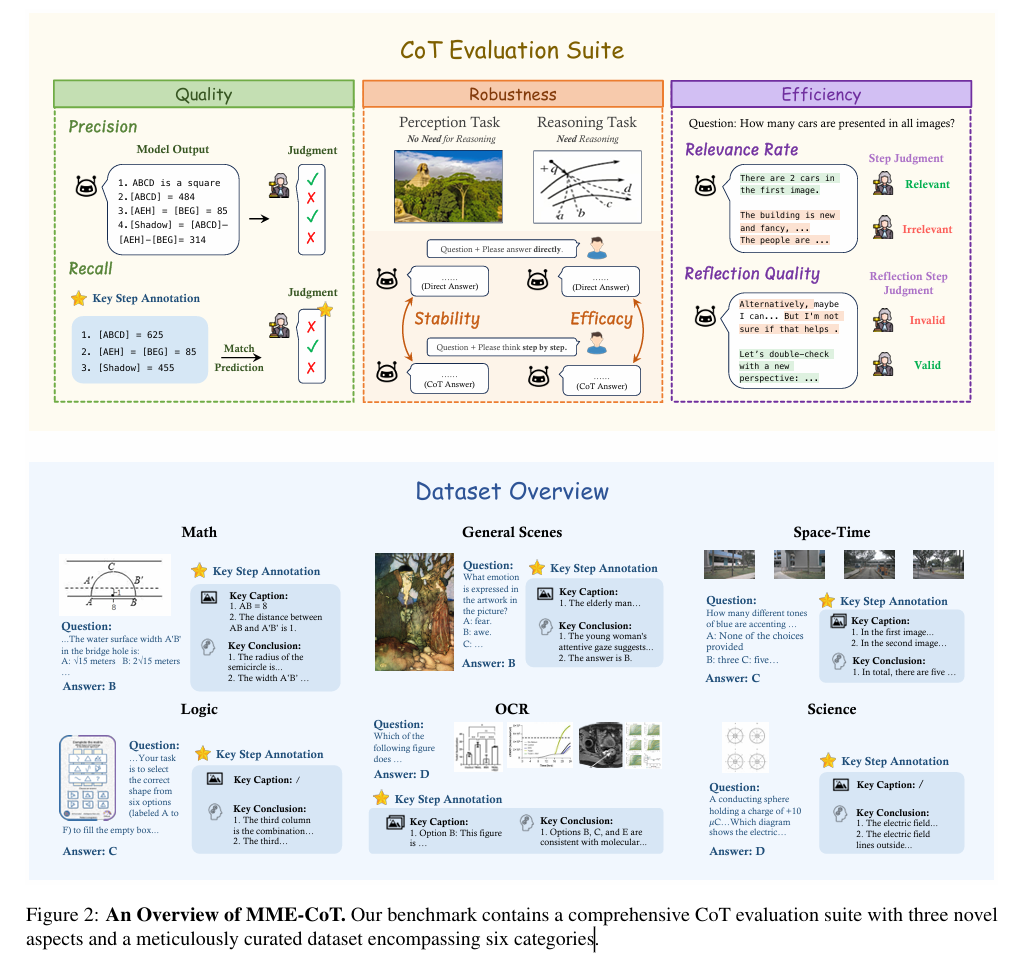

1) MME-CoT 基准体系

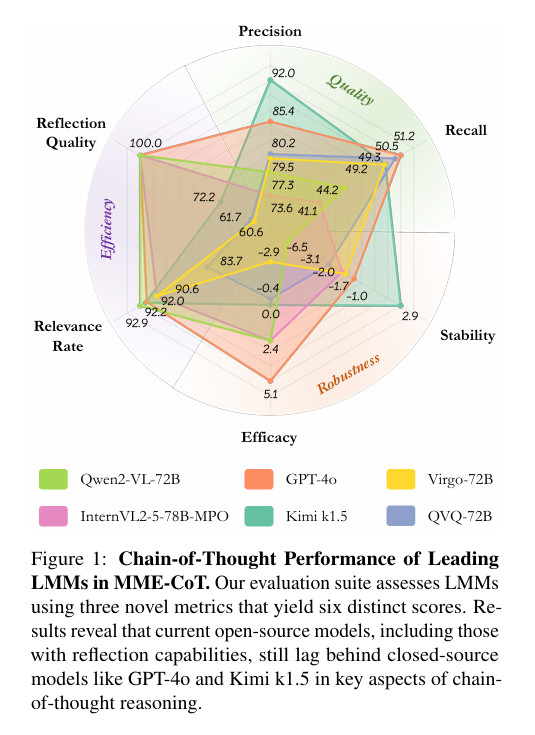

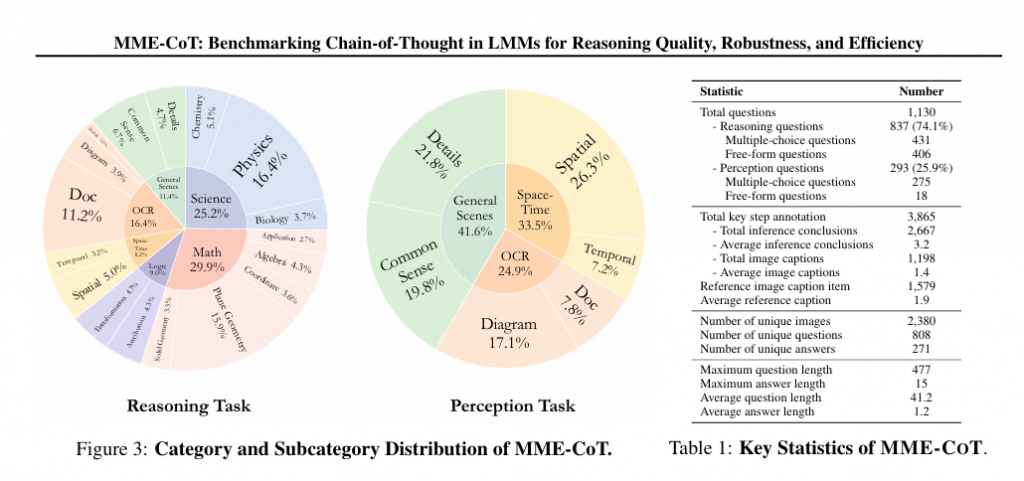

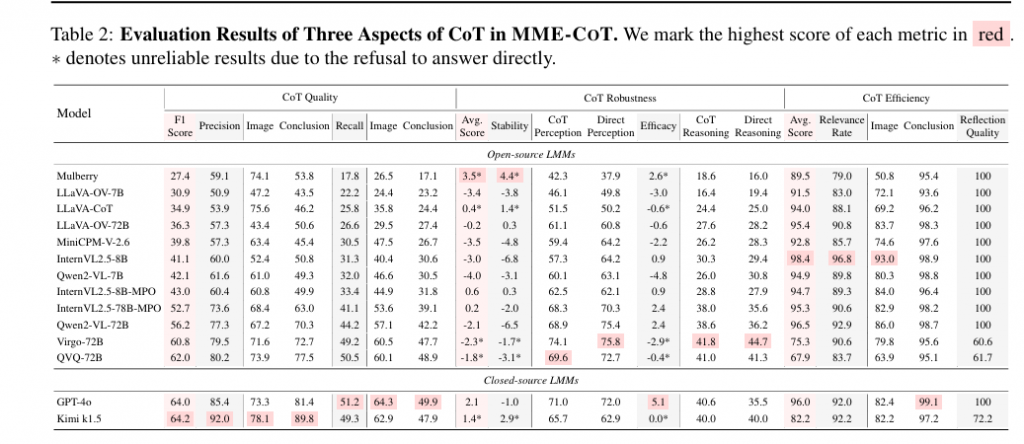

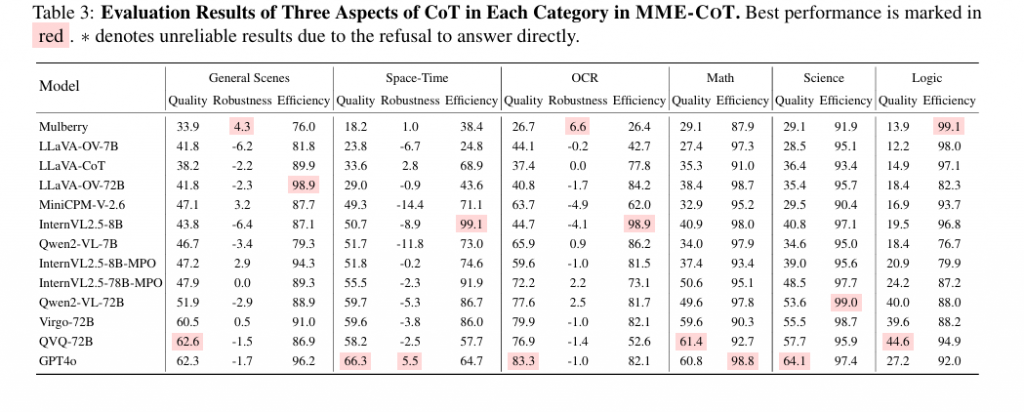

论文提出了一个专门的 benchmark —— MME-CoT,重点评估 LMMs 在多模态推理任务中的质量、稳健性与效率。这个体系包含:

- 六类任务域:包括数学、科学、OCR(光学字符识别)、逻辑、时空分析与常规场景理解,覆盖语言、视觉与逻辑交互的复杂推理场景;

- 三个全新评估指标:

- 推理质量(Quality):衡量模型输出推理的逻辑性与准确性;

- 稳健性(Robustness):测试模型对输入扰动(如噪音图像、文本变化)的敏感度;

- 推理效率(Efficiency):评估推理步骤数、生成时间与资源消耗。

这一全面指标体系可较细粒度地衡量多模态推理能力,而不仅仅依赖最终答案准确率。

2) 对先进 LMMs 的系统评估与洞察

论文通过 MME-CoT 对当时最强的多模态模型(包括带有 reflection 机制的模型、GPT-4o 等)进行了大规模测试,得到三大关键结论:

(1)带反思(reflection)机制的模型拥有更高的 CoT 质量

一些最新架构引入了反思机制(reflection,使模型在生成答案时同时“审视”生成过程)。实验表明,这类模型在推理质量上显著优于其他模型,在某些任务上甚至超过 GPT-4o。这显示增强内部推理过程比单纯增加参数有效。

(2)CoT 提示在感知密集任务上效果不佳

在涉及视觉细节处理的推理任务中(如需要准确阅读图像内容或空间关系辨认),使用 CoT 提示反而降低了表现。论文指出,这可能是因为:

- CoT 扩大了“过度思考(overthinking)”行为,对感知细节敏感的任务不适合冗长推理;

- 多模态输入导致的噪音干扰 CoT 推理链的稳定性。

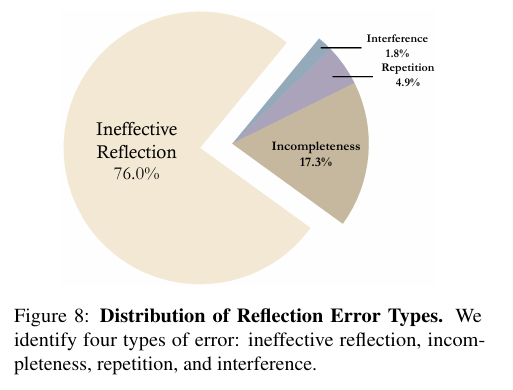

(3)反思机制提升质量但降低效率

反思机制可提升多模态 CoT 的输出质量,但在推理效率上存在明显折衷:

- 生成链越长、模型资源消耗越大;

- 像反思阶段的自我检查步数增加延迟与成本,使模型在实际部署中效率较低。

这些发现为如何使用 CoT 提示和架构改进提供了实证性指导。

三、研究方法与技术细节

1) MME-CoT Bench Design

- 任务域涵盖多类型跨模态推理场景,从数学图表理解、科学常识推理到OCR 图像阅读再推理等;

- 每类任务包含高质量、多样化的样本以评测不同层面的能力(逻辑、数学、视觉理解等)。

2) 三大评估指标

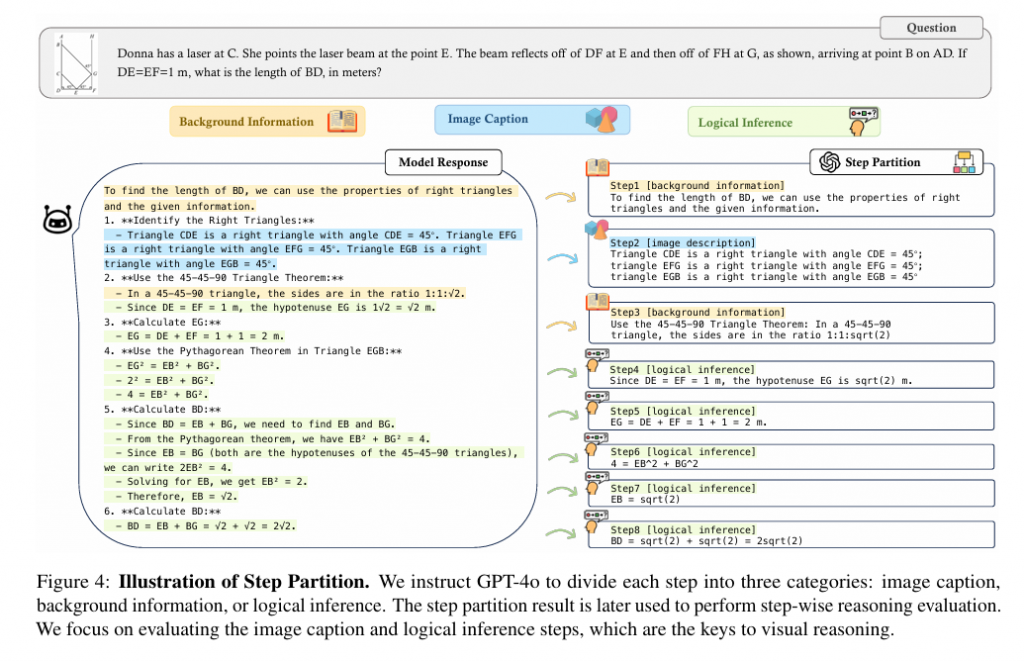

论文提出的指标不只是看最终正确率,还在推理结构上做深入分析:

- Quality Metrics:结合推理链条与最终答案的连贯性、正确性打分;

- Robustness Metrics:通过添加噪音、扰动后的稳定性测试模型对微小变化的敏感度;

- Efficiency Metrics:统计推理过程中生成 token 数、反思/自纠错步数与计算消耗。P

这种评估方式允许对比模型在不同推理策略下(直接回答 vs Chain-of-Thought vs Reflection)表现的差异,真正衡量推理质量而不仅是输出准确性。

四、实验与结果总结

论文在多个模型上做了广泛横向对比:

- 反思机制模型(reflection models)在多数推理任务上表现最佳;

- 标准 CoT prompting 会在视觉感知密集任务表现弱于无 CoT;

- GPT-4o 等强大的商业模型虽然表现优异,但在某些 domain-specific 推理(如 OCR +逻辑)仍落后于最先进研究模型。

这些实验结果揭示出多模态推理不同于纯文本推理的本质:图像与文本信息对准确推理链构建有截然不同的需求。

五、创新点与意义

该论文的主要创新与贡献包括:

1. 第一个系统评估多模态 LLM 推理链能力的 benchmark

MME-CoT 提供了从质量、稳健性与效率三个维度的综合测评方法,为多模态推理研究提供了标准化评价体系。

2. 对 CoT 在多模态任务中的适用性提出实证结论

实验证明:

- 思维链对某些视觉逻辑任务未必有益;

- 引入反思机制可以提升逻辑质量但牺牲效率。

这种实证分析对于构建更擅长跨模态推理的 LMMs 架构具有重要指导意义。

3. 被验证的模型表现洞察指导未来模型设计

论文指出未来改进方向包括:

- 更适合视觉推理的 CoT 形式(如视觉链提示);

- 与反思机制结合的高效架构设计;

- 更稳健的 multimodal grounding 与 reasoning 模块。

六、结论与未来方向

结论: 论文首次提出了对多模态大模型跨模态推理三维度的评价体系,并基于此体系实证发现:

- 现在最先进的大模型在思维链方面已经具备某些优势;

- CoT 并非在所有跨模态任务中均有效;

- 反思机制能够提升质量,但需要权衡效率。

未来方向: 研究者应重点关注如何使推理链对视觉感知任务更有效、提高跨模态稳定性、优化推理效率,以及构建更全面的 reasoning 基准