一、研究背景与挑战

任务定义:3v3 多无人机排球(Multi-Drone Volleyball)

该任务要求三台无人机组成一个团队与另一个三机团队进行排球比赛。它同时具有以下挑战性:

- 高层策略与低层控制耦合:需要在物理环境中做出战术决策(如团队配合、球路选择)并执行具体动作。

- 多智能体协同与竞争:3v3 形式要求团队成员之间紧密合作,同时在对抗中不断调整策略。

- 复杂物理动力学:无人机具备欠驱动特性(即某些运动不可直接控制),使得精细动作学习成为独立问题。

- 长时序依赖与回合制结构:比赛过程跨越多个连续时刻,决策效果可能在较长时间范围内显现。

此外,该任务与过去的单一无人机控制任务不同,它更加类似典型的 embodied competitive multi-agent RL 环境,需要策略和控制一体化地学习。

二、方法:Hierarchical Co-Self-Play (HCSP)

为了解决上述挑战,作者提出了 Hierarchical Co-Self-Play (HCSP) —— 一种分层的强化学习框架,将 高层策略决策 与 低层运动控制 分开处理,并设计了一个三阶段的训练流程。

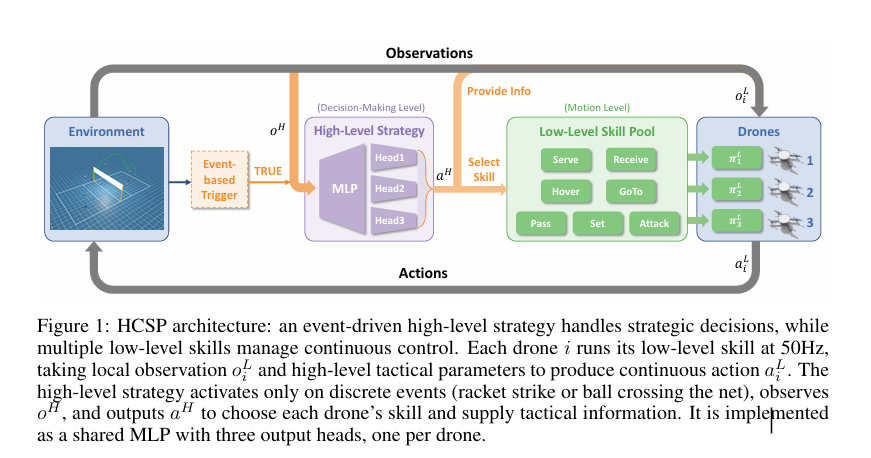

2.1 分层策略结构

HCSP 将策略分成两个层次:

1. 高层策略 π⁽ᴴ⁾(High-Level Strategy)

- 功能:负责团队整体战术决策,如为每一台无人机选择低层技能和战术参数。

- 结构:集中式网络(MLP),包括三个输出头,每个输出头分别控制一个队员的低层技能选择。

- 控制时机:仅在离散游戏事件(例如击球或球过网)发生时触发,反映排球比赛的回合制特性。

2. 低层策略 π⁽ᴸ⁾(Low-Level Skills)

- 功能:面向具体的无人机动态控制,比如推力调整与姿态控制。

- 结构:每个无人机拥有独立低层控制器,在高频率(如 50 Hz)上运行,提供对物理动态的实时调整。

- 观察空间:主要包括当前无人机状态和球的物理信息,不包含战术层面的全局信息,以保持专注物理执行。

这种分层设计使得 高层关注长期协同与战术逻辑,低层关注具体动作执行,从而分离任务的不同复杂性。

2.2 三阶段训练流程

HCSP 的核心在于三阶段的训练管线,旨在让低层技能和高层战术从零开始自发学习,无需专家演示。

✦ Stage I — 低层技能自学习(Low-Level Skill Acquisition)

- 目标:训练独立无人机的基础动作技能,如移动到目标位置、在空中调整姿态、迎击球等。

- 方法:

- 将低层策略作为单独 RL 任务训练;

- 使用 reward shaping 来加速学习(例如接近球或保持平衡带来即时奖励)。

- 关键技术:

- Policy Chaining:逐步训练低层技能,使其能在时间维度上平滑过渡不同动作。

- 高频率动作执行(如 50 Hz),保证细粒度控制。

这阶段的主要目标是让无人机具备基础飞行与球交互技能,为后续高层训练准备稳定的执行模块。

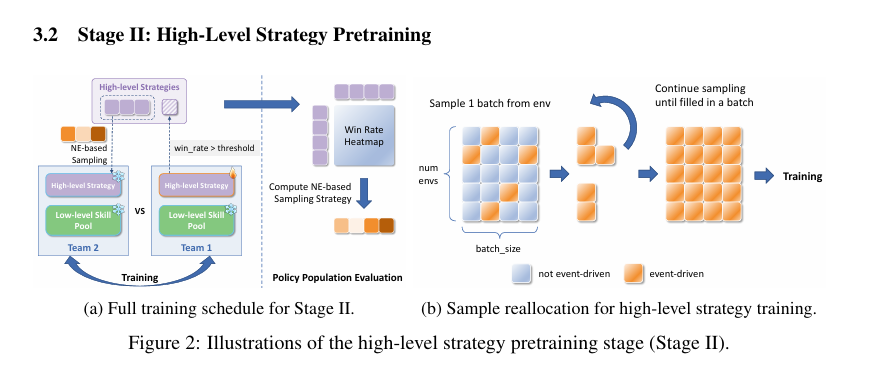

✦ Stage II — 固定低层策略的高层自博弈(High-Level Self-Play Strategy Learning)

- 在 Stage I 完成后,冻结低层控制器,将它们作为固定模块供高层策略调用。

- 高层策略通过**自我对抗(self-play)**训练来学习团队协作与竞争战术。

- 为了增强策略多样性和鲁棒性,该阶段采用了基于种群的人口训练机制,让高层策略与不同版本的战术进行对抗。

这阶段的收益在于让高层专注于长期决策、阵型安排、球路选择等逻辑,而不被低层物理控制干扰。

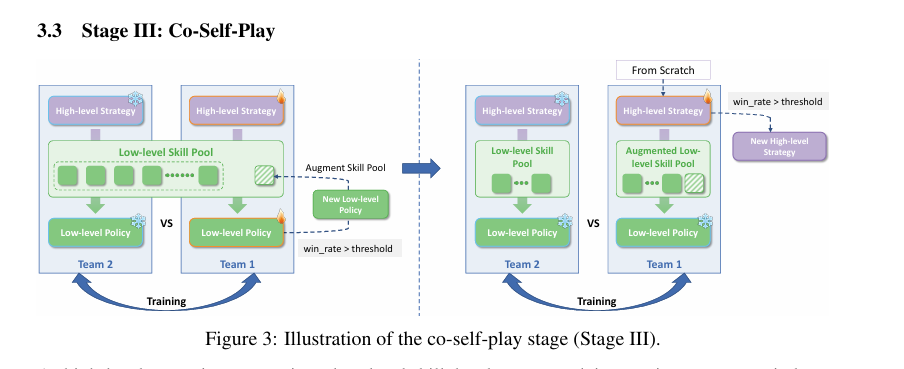

✦ Stage III — 协同自博弈联合微调(Co-Self-Play Fine-Tuning)

- 最后一阶段是将高层和低层策略联合训练,使两个层次彼此适配。

- 联合训练的关键技术包括:

- 让高层奖励影响低层学习,从而使低层优化不仅考虑自身即时执行表现,也能服务更高层次的战术目标。

- 为减少 reward 稀疏性,在低层 reward 中加入一项 KL 惩罚,以限制低层策略偏离其参考策略过远。

这一阶段的结果通常会体现为更协调的动作序列和更稳健的团队表现。

三、策略与网络参数化

• 高层策略网络

- 输入:当前游戏状态(包括球位置、无人机位置、历史动作信息等)。

- 输出:每台无人机的低层技能选择 + 战术参数。

- 网络结构:统一 MLP(多层感知机)共享底层表示,三个输出头分别负责每台无人机。

• 低层策略网络

- 输入:本机观测(自身状态 + 球动态)。

- 输出:连续动作如推力、角速度等。

- 网络采用独立参数化策略,由高频 RL 算法(如 PPO/TD3 类方法)训练。

这种结构允许 高层以稀疏事件作为决策时刻,低层执行细粒度控制,有效减少训练噪声并提升学习效率。

四、训练机制细节

• 人口训练与样本重分配

在 Stage II 中引入种群训练(population-based training),使高层策略面对多个版本的对手,有助于避免过拟合单一对手策略,提升策略鲁棒性。

• 奖励设计

- 高层主要依据比赛胜负与关键事件获得稀疏奖励;

- 低层在 Stage I 由densified reward shaping 提供信号;

- 在 Stage III,低层奖励整合来自高层的 reward 和与参考策略的 KL 惩罚,提升稳定性。

五、实验结果

该论文在 VolleyBots 3v3 任务 上进行了大规模比较实验,并与下列基线进行对比:

- 非分层自博弈(flat self-play)

- 基于规则的分层策略

- 两阶段训练变体(无联合微调)

关键性能指标(平均胜率):

| 方法 | 胜率(平均 vs Baselines) |

|---|---|

| HCSP (完整三阶段) | 82.9% |

| Two-stage variant (Stage I + II) | 71.5% |

| Non-hierarchical/self-play | 显著更低 |

此外,在 Stage III 联合训练的情况下,出现了一些团队协作行为,例如角色切换、协调阵型,这些在 Stage II 或 baselines 中未明显出现。

六、核心贡献与创新点

- 引入 HCSP:首个用于高维物理 multi-agent 竞技任务的分层自对抗 RL 框架。

- 三阶段训练:分别解决低层技能、战术策略和联合优化,使学习更稳定且更具逻辑分层。

- 联合微调机制:通过 co-self-play 让不同层互相调整,提高最终协作策略。

- 实证验证:在高难度 3v3 多无人机竞技任务中显著超过 baselines,并展示复杂行为的 emergent emergence。

七、技术局限与未来方向

论文中指出几点未来改进或开放问题:

- 训练成本高:三阶段训练管线对算力和样本效率要求较高。

- reward 稀疏性:高层奖励仍然稀疏,尽管 Stage III 有缓解机制但改进空间仍然存在。

- 真实部署挑战:尽管在模拟器上验证,跨到真实无人机可能面临 dynamics gap 和可靠性问题(虽然 VolleyBots 提供了 sim2real 的基础)。

八、总结

这篇论文提出了一种面向复杂 multi-agent embodied 强化学习任务的 分层自对抗学习框架 HCSP,通过分解高层战术与低层控制问题,并采用三阶段训练流程,使得 3v3 多无人机排球这一复杂竞技任务可以从零开始学习出有效策略。实验证明 HCSP 能学习 emergent 的团队协作行为,并大幅性能优于传统 baselines。