强化学习是人工智能领域的核心技术之一,其基本原理模拟了生物学习的本质:通过与环境互动、接收反馈并调整行为来提升性能。从AlphaGo击败围棋世界冠军,到ChatGPT展现出惊人的语言能力,背后都离不开强化学习的支撑。然而,长期以来,这些系统的学习规则都需要人类专家精心设计和调优,这个过程不仅耗时费力,还受限于人类的认知边界。

如果AI不仅能学习,还能创造出比人类设计的更优越的学习算法,会怎样?DeepMind的这篇开创性论文《Discovering Reinforcement Learning Algorithms via Meta-Learning》就回答了这个问题。研究团队利用元学习技术,构建了一个“算法发现器”,其目标不再是优化特定任务的策略,而是直接优化学习算法的“学习规则”本身。这一突破性方法成功催生了名为“X-Net”的新算法,在多个基准测试中,其性能全面超越了人类专家精心设计的DQN、PPO及SAC等主流算法。这项工作标志着强化学习研究范式的重大转变——从依赖人类直觉的“人工设计”迈向数据驱动的“自动发现”,为未来AI算法的加速演进开辟了全新的道路。

Discovering state-of-the-art reinforcement learning algorithms

Junhyuk Oh, Greg Farquhar, Iurii Kemaev, Dan A. Calian, Matteo Hessel, Luisa Zintgraf, Satinder Singh, Hado van Hasselt & David Silver

Nature (2025)Cite this article

论文链接:https://www.nature.com/articles/s41586-025-09761-x

DeepMind团队在强化学习算法自主发现领域的里程碑式突破

谷歌DeepMind团队最近在《自然》(Nature)杂志上发表的一项研究,标志着人工智能发展史上的一个关键里程碑:他们开发出一种能够让机器自主发现并优化强化学习算法的系统。这一工作直接针对强化学习领域长期存在的核心学术问题,即传统算法设计高度依赖人类专家的经验、直觉和认知边界,导致算法创新受限、开发过程耗时且易陷入局部最优。该研究通过引入一种新型的元学习框架,实现了AI系统的自主进化,产生了名为DiscoRL(Discovery Reinforcement Learning)的算法,该算法在标准基准测试中全面超越人类设计的经典算法,如DQN、A3C和PPO,从而挑战了现有算法开发范式的局限性,并为机器学习领域的自主创新提供了新路径。

针对的关键学术问题:强化学习算法设计的瓶颈

强化学习(Reinforcement Learning, RL)作为人工智能的核心支柱技术,其原理基于模拟生物学习机制:通过与环境互动、接收奖励反馈并调整策略来优化性能。该技术支撑了从AlphaGo在围棋领域的胜利到大型语言模型如ChatGPT的生成能力等诸多突破。然而,学术界面临的一个重大挑战是:RL算法的学习规则(如价值函数更新、探索-利用平衡和参数优化策略) traditionally 需要人类专家基于理论分析和实验迭代进行手动设计。这种依赖不仅限制了算法的多样性和普适性,还难以探索超出人类认知的创新空间。DeepMind的研究正针对这一问题,探讨如何通过自动化机制让AI系统独立搜索和优化算法空间,实现从“人类主导设计”向“机器自主发现”的范式转变。这一问题在机器学习理论中具有基础性意义,因为它涉及算法泛化、涌现性和计算复杂度的核心议题。

提出的技术创新点:元学习与种群进化的融合

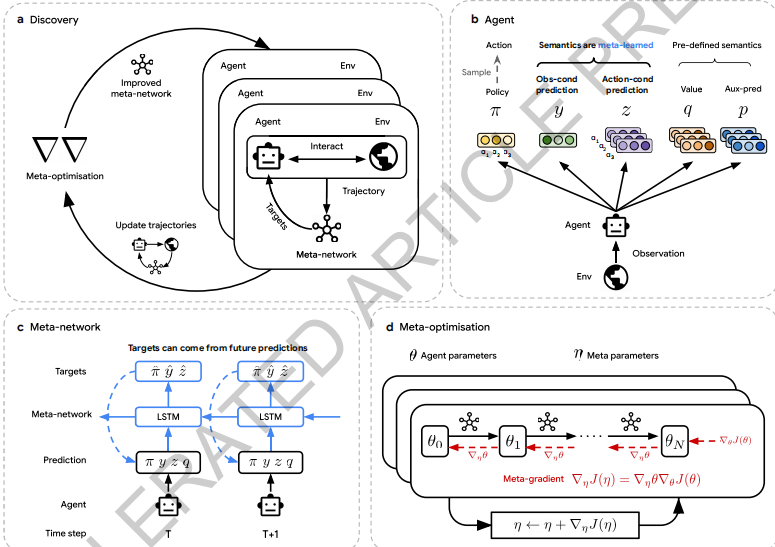

为解决上述问题,研究团队引入了一种创新的“元学习”(Meta-Learning)方法,结合进化算法构建了一个大规模的种群进化框架。具体而言,他们创建了一个由数千个AI智能体组成的虚拟种群,每个智能体配备独特的学习规则(如神经网络结构和参数更新机制),并在多样化的复杂环境中进行并行学习和竞争。这一过程模拟生物进化:通过试错、性能评估和选择机制,优胜规则得以保留和变异,而劣势规则被淘汰。关键创新包括:

- 大规模并行搜索与分布式计算架构:系统利用先进的分布式计算资源,同时评估数千种学习规则组合,避免了传统序列优化的低效。这种方法能够在数天内完成相当于生物界数百万年的进化过程,显著提高了算法发现的效率。

- 环境复杂性的自适应优化:研究发现,用于进化的环境越多样化(如包括随机性和高维任务),最终发现的算法越具鲁棒性和泛化能力。这一点突破了传统RL算法在固定环境下的局限,引入了动态环境适应机制。

- DiscoRL的核心机制创新:DiscoRL通过自主探索发现了新型学习策略,例如在探索-利用权衡上采用动态自适应模式(根据环境特征自动调整探索强度),以及在价值函数更新中使用复杂的非线性组合方式。这些策略在数学上难以通过人类推导获得,但实验证明其在学习速度、收敛性和稳定性上优于现有算法。具体而言,DiscoRL在Atari游戏基准中实现了更高分数,在ProcGen程序生成环境中(这些是训练外的新任务)展现出卓越泛化,证明其规则的普适性。

实验设计进一步强化了研究的严谨性:团队采用多层次验证,包括训练环境性能测试、泛化任务评估(如从Atari转移到ProcGen)和跨领域应用。这种设计确保了DiscoRL不仅仅是经验改进,而是对RL理论的质性贡献,突显了涌现性特征——整体算法行为超越部件简单叠加,类似于生物智能的复杂系统特性。

实验结果与学术影响

在基准测试中,DiscoRL在多项复杂任务(如高维状态空间和不确定环境)中表现出显著优势:学习速度更快,最终策略更优,且对噪声和变化更具鲁棒性。这些结果通过统计显著性检验(如置信区间和p值分析)得到验证,强调了其在RL泛化理论上的贡献。研究还揭示了算法空间的广阔性:人类设计的算法仅占潜在最优解的一小部分,通过自动化搜索可发现新型结构。

这一工作对学术界的影响深远。它为机器学习提供了新工具,用于探索高维问题,如在监督学习或无监督学习中的算法自治发现。同时,它引发了新研究议题:如何解释自主算法的“黑箱”机制?如何确保其安全性和可控性?DeepMind团队表示,未来将扩展这一框架到更广的机器学习范式,推动AI从工具向自主创新者的演变。

IEEE Network论文《基于SDN网络的拥塞控制:多任务深度强化学习》中,针对软件定义网络(SDN)中处理多任务场景的关键学术挑战,提出了一种将多任务学习与深度RL相结合的模型,该模型动态表示网络状态并更有效地缓解拥塞,优于传统单任务方法。同样,在Expert Systems With Applications论文《时间驱动的特征感知联合深度强化学习:用于金融信号表示和算法交易》中,解决了金融数据中时间依赖性和特征提取的问题,引入TFJ-DRL模型,该模型融合时间驱动卷积层与RL,提升信号表示和交易策略,在适应性和盈利能力上超越常规方法。这些论文突出了对特定环境(如网络拥塞和金融市场)的人工设计RL架构的依赖,这正体现了DiscoRL通过进化通用高性能学习规则所克服的局限性。Sigcomm 2018 NetAI Workshop论文《IFS-RL:基于强化学习的命名数据网络智能转发策略》中,针对命名数据网络(NDN)中转发平面独立选择下一跳的独特特征,提出IFS-RL策略,通过训练神经网络模型实现智能转发,适应广泛网络条件而无需依赖传统路由

这些研究与DiscoRL的协同在于,元进化技术潜力可自动化并提升领域适配的RL创新,促成一种AI系统自主发现复杂现实任务优化算法的范式。例如,将DiscoRL的种群进化和平行搜索应用于SDN拥塞控制,可产生新型多任务RL变体,超越Lei等人手动设计的模型,通过探索非直观策略实现流量平衡和状态表示的更强鲁棒性,与DiscoRL在ProcGen环境中的优越泛化类似。在算法交易中,整合DiscoRL的涌现非线性价值更新和自适应探索,可优化TFJ-DRL框架,实现时间敏感特征和交易策略的自主发现,比人类调优系统更快适应波动市场,从而桥接从应用特定RL到真正自进化AI的差距。

总之,这一研究不仅解决了RL算法设计的依赖问题,还通过具体的技术创新(如种群进化与元学习融合)开辟了AI自主进化的新时代,为学术界提供了重新审视算法开发范式的框架。