Hao Ge (Peking University); Junda Feng, Qi Huang (ByteDance Inc.); Fangcheng Fu (Shanghai Jiao Tong University); Xiaonan Nie, Lei Zuo, Haibin Lin (ByteDance Inc.); Bin Cui (Peking University); Xin Liu (ByteDance Inc.)

ByteScale: Communication-Efficient Scaling of LLM Training with a 2048K Context Length on 16384 GPUs

报道人:方明俊(SNG 三年级硕士生)

介绍

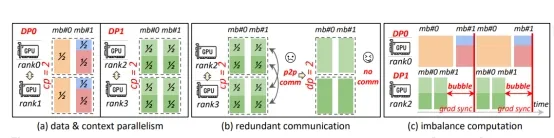

本文重点研究随着上下文长度扩展到数十万甚至数百万token级别时,大规模语言模型(LLM)训练中出现的通信瓶颈问题。现有的方法要么依赖数据并行,要么依赖上下文并行,但两者都存在严重的效率问题。数据并行在序列长度增加时通信成本急剧上升,而上下文并行在处理长短序列混合时会造成资源浪费。作者认为,问题的根源在于当前并行化策略的僵化,即对所有序列采用相同的分区方案,导致设备利用率低和跨设备等待时间过长。这一分析为ByteCycle的设计提供了动机。

核心思想与贡献

ByteCycle的核心思想是提出一种新的混合并行范式,将数据并行和上下文并行融合到一个统一的通信模型中,并根据序列长度动态调整。其贡献是多方面的:首先,它引入了一种选择性卸载机制,使得短序列可以完全在单个GPU上处理,无需不必要的跨设备同步,而仅对长序列进行分布式处理;其次,它开发了一种新颖的微批量调度方法,确保即使在异构序列长度下也能实现负载均衡,从而最小化流水线气泡和空闲时间;第三,它提供了一种轻量级的数据感知通信优化器,使该方案能够扩展到数万个GPU。这些贡献并非孤立的技巧,而是代表了分布式训练设计的一种范式转变,重新定义了在极长上下文训练中应如何协调并行化。

实验评估

作者在由16,384个GPU组成的大规模集群上进行实验,涵盖了从7B到70B参数的LLaMA等稠密模型,以及Mistral 8×7B和8×22B等稀疏混合专家(MoE)模型,上下文长度最高扩展到2,048K。在GitHub数据集上,基线系统在上下文长度加倍时吞吐量几乎减半,而ByteCycle的吞吐量仅下降1.08倍,显示出在长上下文下的卓越稳定性。在Byted数据集上,尽管序列分布带来了额外挑战,ByteCycle仍然显著优于现有系统。报告的最大加速比达到了令人印象深刻的7.89倍,远超现有最先进基线,为长上下文训练设立了新的标杆。进一步的消融研究证实,选择性卸载、均衡调度和远程数据加载各自都做出了可衡量的贡献,确保性能提升是整体设计的直接结果,而非某一优化的偶然产物。总之,评估结果表明ByteCycle是一个稳健且可扩展的框架,从根本上改变了长上下文LLM训练的可能性。

问答环节

Q1: 你们提出了混合数据并行和动态选择性卸载,并在16,000个同构CPU上研究了性能。那对于异构GPU集群(例如显存大小、互连速度不同),性能敏感性有什么经验或看法吗?

A1: 性能确实会受到影响,因为通信带宽和计算能力存在差异。关键在于如何更好地实现通信和计算的重叠。如果使用不同类型的GPU,可能需要调整每个rank处理的token数量,以更好地实现重叠。

Q2: 你们的工作主要针对LLM训练并优化了通信与计算的重叠,那么类似的思路能否应用到LLM推理阶段?

A2: 可以的,类似的思路同样适用于推理,特别是长上下文推理。在推理时也有如上下文并行、序列并行等方法,但需要特别注意长序列和短序列之间的平衡。

个人观点

这篇文章的核心思想——根据序列实际长度动态组装通信组,而非静态网格,给我留下了深刻印象。这不仅仅是一项优化——更是一种范式转变,它承认了真实数据中固有的异构性。我认为分布式训练系统的未来应该是像文章提出的那样:自适应、数据感知且流动的。然而,虽然实验达到了7.89倍的显著加速比提升,但是我认为我们哈还需要关注其动态调度机制的系统性开销。论文出色地优化了GPU时间,但并没有讨论其CPU端的成本:包括持续分析序列、为每一个微批次用公式(3)求解优化问题、以及通过Ray协调远程数据加载器。在他们16K GPU的巨大规模下,这种元数据管理和调度决策的开销可能会成为一个不可忽视的瓶颈,可能进一步限制可扩展性,或使系统对主机性能异常敏感。