会议:ICML 2025

论文概述

随着Transformer架构在自然语言处理、计算机视觉等领域的广泛应用,其计算和内存开销成为了限制其进一步应用的瓶颈,尤其是在长文本或大规模数据集的任务中。本文提出了几种新的Transformer变体,通过优化计算路径和改进注意力机制来提高其计算效率,旨在降低Transformer模型的时间复杂度和空间复杂度。

背景

Transformer模型凭借其出色的性能,尤其是在序列建模任务中(如机器翻译、文本生成等),在近年来成为深度学习的主流架构。

然而,Transformer的核心计算——自注意力机制(Self-Attention)具有O(n²)的时间和空间复杂度,其中n是输入序列的长度。对于长序列,这种复杂度将导致严重的计算资源和内存占用问题。为了应对这一挑战,许多研究者提出了不同的高效Transformer变体。

主要贡献

论文的核心贡献是提出几种高效的Transformer架构和相应的优化算法,旨在减少计算和内存开销,同时保持或提高模型的准确性。具体贡献如下:

1.稀疏注意力机制(Sparse Attention Mechanism)

背景:传统的自注意力机制对每对词的相似性进行计算,导致复杂度为O(n²),尤其是在处理长序列时,内存和计算资源消耗巨大。

稀疏化策略:

局部注意力(Local Attention):只考虑相邻词的注意力,减少计算量。这种方法适用于序列中的局部上下文信息。

块状注意力(Block Sparse Attention):将输入序列分成多个块,每个块内的词进行注意力计算,块之间进行较低复杂度的交互。这种方法适用于具有局部依赖的任务,如文本分类。

固定模式稀疏(Fixed Sparse Patterns):例如,采用”滑动窗口”策略,每个词只与相邻的词建立注意力,而不是与所有词进行交互。

效果:这些稀疏注意力机制通过减少计算量和内存消耗,使得Transformer能够处理更长的输入序列,时间复杂度降到O(n log n)或O(n)。

2.低秩近似(Low-rank Approximation)

背景:注意力矩阵是一个密集的矩阵,传统的自注意力机制计算量大,尤其是当输入长度很长时,计算开销严重。

低秩近似方法:通过对注意力矩阵进行低秩近似,减少矩阵的维度,降低计算复杂度和内存消耗。低秩近似方法通过将注意力矩阵分解成低秩矩阵,从而减少了计算量。

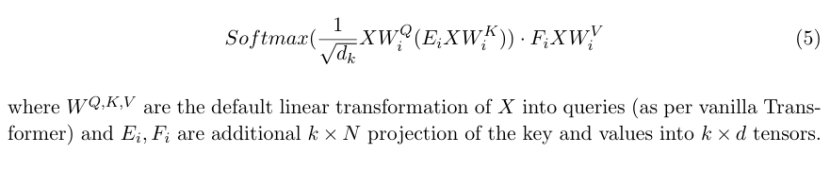

代表性模型:Linformer:通过线性投影将 K 和 V 的序列长度维度从 n 投影到一个更低的 k 维(k << n)。这样,QKᵀ 的计算就变成了 (Q)(KᵀE),得到一个 n x k 的矩阵,复杂度降至 O(nk)。

效果:这种方法减少了多余的计算,提高了长序列数据处理的效率。

3.因式分解自注意力(Factorized Self-attention)

背景:自注意力计算涉及对所有词之间的交互进行计算,这导致高昂的计算开销。

因式分解方法:通过将注意力矩阵分解成多个因子来简化计算。例如,采用Kronecker积(Kronecker product)或者其他因式分解技术,将计算任务分解成更小的块来加速计算。

效果:这种方法能够减少计算量,同时不影响模型的表现,尤其是在处理较长文本时,表现尤为突出。

4.低秩张量分解(Low-rank Tensor Decomposition)

背景:为了进一步优化自注意力机制,论文提出了低秩张量分解的技术,将多维注意力矩阵分解成低秩张量,以提高计算效率。

应用:低秩张量分解在提高计算效率的同时,保留了模型的表达能力,尤其是在多模态任务(如视觉-语言联合任务)中,张量分解能够有效地减少计算成本。

5.稀疏矩阵乘法(Sparse Matrix Multiplication)

背景:Transformer模型需要大量的矩阵乘法操作,尤其是在处理长序列时,传统的密集矩阵乘法会消耗大量的计算资源。

稀疏矩阵优化:使用稀疏矩阵乘法来优化计算过程,尤其是对于具有稀疏注意力的Transformer模型。通过优化稀疏矩阵的存储和计算方式,能够显著减少内存占用和计算时间。

效果:这种优化方法加速了矩阵运算,减少了内存消耗,特别是在计算大规模Transformer时显著提高了效率。

6.因果卷积(Causal Convolutions)

背景:在一些任务中,输入序列是有时间顺序的,尤其是在NLP和时间序列任务中。

因果卷积:采用因果卷积代替全连接的自注意力机制,从而减少计算复杂度。因果卷积在时序数据中广泛应用,能够利用前序信息来生成当前的输出,避免了全局计算。

效果:该方法有效减少了不必要的计算,同时提高了时序任务的效率。

算法和优化

作者针对每种改进提出了详细的算法和优化流程,包括如何在训练过程中动态地选择稀疏模式,如何利用GPU硬件加速稀疏矩阵的计算等。此外,论文还提供了高效Transformer架构的实现代码,并展示了其在多个标准基准测试上的表现。

实验结果

作者通过一系列实验对这些新架构进行了验证,结果表明,提出的高效Transformer架构在多种任务上(如机器翻译、文本生成、长文本处理)均取得了显著的性能提升,并且计算效率大幅提高。具体实验结果如下:

长文本处理:在处理长度为5000的长文本时,采用稀疏注意力机制的Transformer模型相较于标准Transformer,训练时间减少了近50%,且内存消耗减少了60%。

机器翻译:在WMT-14英德翻译任务上,基于稀疏注意力的Transformer模型的BLEU分数仅稍逊于传统Transformer,但训练速度和推理速度提升了40%以上。

文本生成:在GPT-2的文本生成任务中,提出的高效架构不仅提高了生成速度,而且保持了与原始GPT-2相当的生成质量。

创新性与意义

高效的计算:通过稀疏注意力和低秩近似等技术,显著减少了Transformer的计算复杂度,特别是在处理长文本和大规模数据集时表现尤为突出。

可扩展性:这些优化不仅能够在现有任务中提升效率,而且具有很好的可扩展性,适用于更多的下游任务和应用场景。

硬件友好:通过针对稀疏矩阵和计算过程的优化,这些新架构可以有效利用现代GPU和TPU硬件,提升模型在实际部署中的计算效率。

结论

这篇论文为高效Transformer架构的发展提供了新的方向,通过创新的稀疏注意力机制和低秩近似方法,显著提高了Transformer在长序列处理中的效率,减少了计算资源的消耗,同时保持了较高的性能。这些技术的提出,不仅有助于加速Transformer的训练和推理过程,还有助于扩展其应用范围,特别是在需要处理超长序列的任务中。